sharing is caring

ist wirklich so!

Vielen Dank fürs Teilen!

Kluge Köpfe filtern für dich relevante Beiträge aus dem Netz.

Entdecke handverlesene Artikel, Videos und Audios zu deinen Themen.

Seit 2005 ist er mit verschiedenen Projekten im Internet aktiv. Er gründete twitkrit.de und die Twitterlesung, organisierte verschiedene Veranstaltungen und betreibt den populären Podcast wir.muessenreden.de. Anfang 2010 begann er das Blog CTRL-Verlust zuerst bei der FAZ, seit September auf eigene Faust, in dem er über den Verlust der Kontrolle über die Daten im Internet schreibt. Seine Thesen hat er im Oktober 2014 auch als Buch veröffentlicht: Das Neue Spiel, Strategien für die Welt nach dem digitalen Kontrollverlust.

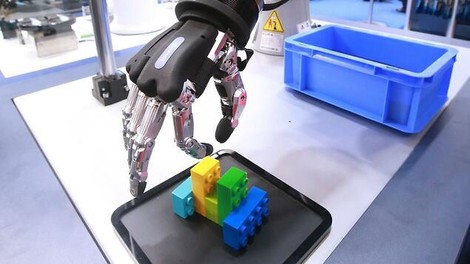

Heiß diskutiert wird seit einiger Zeit die Frage "Ethik in der Künstlichen Intelligenz". Das hat viele Gründe. Seit Jahren wird zum Beispiel das Themenfeld Algorithmen-Ethik diskutiert – also welche ethischen Grenzen und Standards sollen gelten, wenn Algorithmen unser Leben regeln. Ich halte diese Diskussion für berechtigt, auch wenn Ethik natürlich ein schwammiges Etwas ist, aber irgendwie muss man die Lücke ja füllen, die von Datenschutz und Gesetzen im Allgemeinen nicht abgedeckt wird und vielleicht gar nicht abgedeckt werden kann.

Ein anderer Grund ist die Rede von "AI-Safety", also die Frage, die Nick Bostrom, Elon Musk und auch der späte Stephen Hawking aufgeworfen haben: Was, wenn wir eine supermächtige KI erschaffen, die uns Menschen dann einfach auslöscht? Die praktische Antwort auf die Frage, wie damit umzugehen ist, lautet "AI-Alignment", also der Versuch, die Motivationen einer Künstlichen Intelligenz mit denen der Menschen in Einklang zu bringen. Das kann man alles für Quatsch halten, aber vielleicht ist es ja nicht schlecht, wenn sich ein paar Leute darüber Gedanken machen.

Irgendwo dazwischen jedenfalls, bewegt sich der Diskurs um "KI-Ethik", also die Frage, wie man menschliche Ethik in heutige KI-Systeme einflechten kann. Das ist vielleicht der Grund, warum bei "KI-Ethik" so kaugummihafte Ungefährheiten mit dem Pathos der Weltrettung präsentiert werden. Es ist kein Zufall, dass in diesem Dickicht der ernsthaften Ungefährheiten KI-nutzende Unternehmen versuchen, ihr Image aufzupolieren.

So diagnostiziert es der sehr geschätzte Thomas Metzinger im Tagesspiegel, der Teil einer solchen KI-Ethik-Kommission war und das Ergebnis in dem Begriff "Ethics Washing" treffend zusammenfasst.

Ich bin mir im Gegensatz zu ihm gar nicht so sicher, ob es überhaupt sinnvolle Ansätze gibt, KI-Ethik zu praktizieren, aber man kann ihm nur zustimmen: Dieser ist es nicht.

Quelle: Thomas Metzinger Bild: imago images / Cord tagesspiegel.de

Einfach die Hörempfehlungen unserer Kurator'innen als Feed in deinem Podcatcher abonnieren. Fertig ist das Ohrenglück!

Öffne deinen Podcast Feed in AntennaPod:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Apple Podcasts:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Downcast:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Instacast:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Apple Podcasts:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Podgrasp:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Bitte kopiere die URL und füge sie in deine

Podcast- oder RSS-APP ein.

Wenn du fertig bist,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in gpodder.net:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Pocket Casts:

Wenn alles geklappt hat,

kannst du das Fenster schließen.